Ley de Poisson

| Ley de Poisson | |

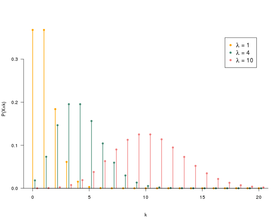

Función de masa Las funciones de masa solo se definen para los números enteros k . | |

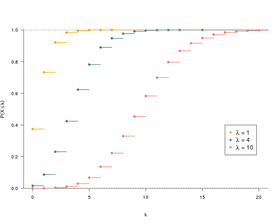

Función de distribución | |

| configuraciones | |

|---|---|

| Apoyo | |

| Función de masa | |

| Función de distribución |

(donde es la función gamma incompleta ) y donde es la parte entera predeterminada de x |

| Esperanza | |

| Mediana | |

| Moda |

si es un real no entero,

y si es un entero |

| Diferencia | |

| Asimetría | |

| Curtosis normalizada | |

| Entropía |

Para grandes:

|

| Función generadora de momentos | |

| Función característica | |

| Función generadora de probabilidad | |

En teoría de probabilidad y estadística , la ley de Poisson es una ley de probabilidad discreta que describe el comportamiento del número de eventos que ocurren en un intervalo de tiempo fijo, si estos eventos ocurren con una frecuencia o expectativa promedio conocida, e independientemente del tiempo transcurrido desde el anterior. evento.

La ley de Poisson también es relevante para describir el número de eventos en otros tipos de intervalos, espaciales más que temporales, como segmentos, áreas o volúmenes.

Historia

La ley de Poisson fue introducida en 1838 por Denis Poisson (1781-1840), en su obra Recherches sur la probabilidad de juicios en asuntos penales y civiles . El tema principal de este libro consiste en ciertas variables aleatorias que cuentan, entre otras cosas, el número de ocurrencias (a veces llamadas "llegadas") que tienen lugar durante un período de tiempo determinado.

Definición

Si el número promedio de ocurrencias en un intervalo de tiempo fijo es λ , entonces la probabilidad de que haya exactamente k ocurrencias ( siendo k un entero natural , k = 0, 1, 2… ) es o :

- e es la base de la exponencial ( e ≈ 2.718 ... );

- k ! es el factorial de k ;

- λ es un número real estrictamente positivo .

Luego decimos que X sigue la ley de Poisson del parámetro λ , denotado .

Por ejemplo, si un determinado tipo de evento ocurre en promedio 4 veces por minuto , para estudiar el número de eventos que ocurren en un período de 10 minutos, elegimos como modelo una distribución de Poisson con parámetro λ = 10 × 4 = 40 .

Cálculo de p ( k )

Este cálculo se puede hacer deductivamente trabajando en una distribución binomial de parámetros ( T ;λT). Para T grande, probamos que la ley binomial converge con la ley de Poisson.

También se puede realizar de forma inductiva estudiando el intervalo [0; T ] las funciones F k ( t ) , que dan la probabilidad de que el evento ocurra k veces durante el intervalo de tiempo [0; t ] . Mediante el uso de recurrencia y cálculo diferencial, logramos encontrar las fórmulas anteriores.

Propiedades

A lo largo de esta sección, X es una variable aleatoria que sigue una ley de Poisson con el parámetro λ .

Momentos y funciones generadoras

Momentos ordinariosLos primeros cuatro momentos ordinarios de una distribución de Poisson están dados por:

Deducimos la varianza y la desviación estándar :

Más generalmente, el n º tiempo ordinario un parámetro de Poisson λ es decirdonde S ( n , k ) es el número de Stirling del segundo tipo de parámetros y .

En particular cuando el n- ésimo momento de X corresponde al n- ésimo número de Bell . De hecho, esto es una consecuencia de la fórmula de Dobiński .

El siguiente límite magnifica los momentos de una distribución de Poisson:Tenemos la relación de recurrencia:

Momentos centradosLos primeros cuatro momentos centrados de una distribución de Poisson están dados por:

Deducimos la asimetría y la curtosis normalizada :

Tenemos la relación de recurrencia:

Momentos factorialesEl r- ésimo momento factorial de una distribución de Poisson es

donde denota el factorial decreciente .

Función generadora de probabilidadLa función que genera las probabilidades de una distribución de Poisson es

Función generadora de momentos

La función generadora de los momentos de una distribución de Poisson es

Demostración

Sea X una variable aleatoria que sigue una distribución de Poisson con el parámetro λ . Recuerda eso por definición .

Esperanza

Diferencia

Función de generador

Recordamos que la función generadora de X está definida por . Entonces obtenemos:

Función generadora de momentos

Recordemos que la función generadora de los momentos de X está definida por . Entonces obtenemos:

Momentos factoriales

Momentos

Los números de Stirling del segundo tipo verifican la relación

.Por lo tanto, al usar la fórmula de los momentos factoriales de una ley de Poisson, así como la linealidad de la expectativa, concluimos que

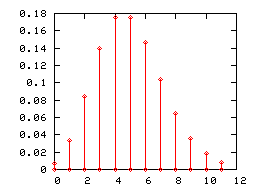

.Gráfico de barras

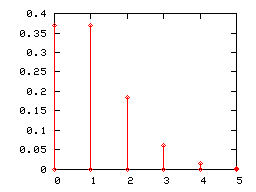

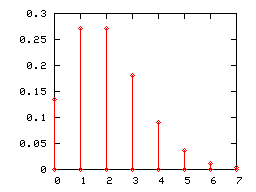

Como cualquier ley de probabilidad discreta , una ley de Poisson se puede representar mediante un gráfico de barras. A continuación se muestran los diagramas de barras de las leyes de Poisson de los parámetros 1, 2 y 5.

Cuando el parámetro de la ley de Poisson λ se vuelve grande (prácticamente cuando es mayor que 5), su diagrama de barras se aproxima correctamente mediante el histograma de una ley normal de expectativa y varianza igual a λ (l 'intervalo de clase es igual a la unidad). Esta convergencia se aprovechó, antes de que se generalizaran los recursos informáticos, para utilizar la ley normal en lugar de la ley de Poisson en determinadas pruebas.

Estabilidad de la distribución de Poisson por la suma

Si las variables { X i } i = 1, ..., n son independientes y siguen una ley de Poisson con parámetros respectivos λ i , entonces su suma sigue una ley de Poisson con parámetro la suma de λ i :

DemostraciónMostramos el caso n = 2 , los casos superiores se deducen por inducción.

Recuérdalo Entonces tenemos

La independencia se utilizó en 2 e iguales. La última igualdad se obtiene mediante la fórmula binomial de Newton .

Terminales de cola

Un argumento de tipo Chernoff bound permite deducir los siguientes límites de cola

para todo x > λ y para todo x <λ .Estos terminales se pueden reescribir de la siguiente manera

para todo x > 0 y para todo λ> x > 0donde para todo . Estos últimos límites implican en particular el siguiente bolardo (que es más débil pero más agradable de manejar)

.El límite superior dado por Chernoff se puede mejorar en un factor de al menos 2

para todo x > 0 .Cabe señalar que la función h está vinculada a la divergencia de Kullback-Leibler entre una ley de Poisson con parámetro x + λ y una ley de Poisson con parámetro λ . De hecho tenemos la relación

.Simulación

Un algoritmo simple para simular la ley de Poisson es usar el siguiente resultado:

Teorema - Sea ( E i ) i ≥ 1 una secuencia de variables aleatorias independientes con la misma distribución exponencial con el parámetro λ . Establecemos S 1 = E 1 y para n ≥ 2 , S n = E 1 + ... + E n . Entonces tenemos:

El método de transformación inversa proporciona una forma sencilla de generar un sorteo aleatorio de acuerdo con una ley exponencial:

Si U sigue una ley uniforme en [0; 1] , entonces E = -1λln ( U ) sigue una ley exponencial con parámetro λ .Por tanto, el algoritmo se puede simplificar mediante:

- k ← 0 , p ← 1

- siempre que p > e –λ

- dibujamos u de acuerdo con un sorteo aleatorio uniforme en [0; 1]

- p ← p × u

- k ← k +1

- devolvemos k - 1

Estimación del parámetro λ

El estimador de máxima verosimilitud del parámetro λ de una muestra derivada de una distribución de Poisson es la media empírica . Es un estimador de convergencia sin sesgos , eficaz , integral (in) , exhaustivo .

Vínculo con otras leyes de probabilidad

- Si X e Y son dos variables aleatorias independientes que siguen las leyes de Poisson de los parámetros respectivos λ y μ , entonces X - Y es una variable aleatoria que sigue una ley de parámetros de Skellam (λ, μ ) .

- Si X e Y son dos variables aleatorias independientes que siguen las leyes de Poisson con parámetros λ y μ , entonces la ley condicional de X conociendo X + Y es una ley binomial .

- Para valores grandes de λ , podemos aproximarnos a la ley de Poisson mediante la ley normal de la media λ y la varianza λ .

Vínculo con la ley de Bernoulli

El recuento de eventos raros a menudo se realiza a través de una suma de variables de Bernoulli , la rareza de los eventos resulta en el hecho de que los parámetros de estas variables de Bernoulli son pequeños (por lo tanto, la probabilidad de que ocurra cada evento es baja). El vínculo entre la ley de Poisson y los eventos raros se puede establecer de la siguiente manera:

Paradigma de Poisson : la suma S n de un gran número de variables independientes de Bernoulli de pequeño parámetro sigue aproximadamente la distribución de Poisson del parámetro

La desigualdad de Le Cam dice que el paradigma de Poisson es una tabla de variables aleatorias independientes de Bernoulli , con los respectivos parámetros p k , n . Apuntamos

Desigualdad de Le Cam : para cualquier conjunto A de números naturales,

En particular, si se cumplen las dos condiciones siguientes:

entonces S n converge de derecho a la distribución de Poisson con el parámetro Eficiencia (estadísticas)

En el enunciado del paradigma de Poisson , hacemos dos suposiciones (ondas) sobre los términos de una suma S n de variables de Bernoulli:

- los parámetros de las variables de Bernoulli son pequeños; sin embargo, las dos condiciones anteriores significan que

que reformula la hipótesis “ los parámetros de las variables de Bernoulli son pequeños ” con mayor precisión;

- hay una gran cantidad de términos; sin embargo, las dos condiciones anteriores conducen a que el número de términos tiende al infinito:

Notas:

- Este paradigma sigue siendo relevante, bajo ciertas condiciones, si relajamos la hipótesis de la independencia .

- Un ejemplo sorprendente es el número de puntos fijos de una permutación dibujados al azar .

- Otro ejemplo es el número de puntos aislados del gráfico aleatorio , cuya convergencia hacia la ley de Poisson permitió a Erdös y Rényi demostrar, en 1960, el teorema de la doble exponencial .

- El caso particular a n = n , p k, n = λ / n , λ n = λ , de la desigualdad de Le Cam, especifica la velocidad de convergencia de la ley binomial de los parámetros n y λ / n hacia la ley de Poisson con el parámetro λ .

Áreas de aplicación

El campo de aplicación de la ley de Poisson estuvo durante mucho tiempo limitado al de eventos raros como suicidios de niños, llegadas de barcos a un puerto o accidentes por patadas de caballos en ejércitos (estudio de Ladislaus Bortkiewicz ).

Pero en las últimas décadas su campo de aplicación se ha ampliado considerablemente. Actualmente, es ampliamente utilizado en telecomunicaciones (para contar el número de comunicaciones en un intervalo de tiempo determinado), control estadístico de calidad (número de defectos en SPC ), la descripción de ciertos fenómenos relacionados con la desintegración radiactiva (la desintegración de los núcleos radiactivos siguientes, además, una ley exponencial del parámetro también señaló lambda), biología ( mutaciones en el experimento de Luria y Delbrück , número de potenciales de acción emitidos por una neurona en neurociencias), meteorología , finanzas para modelar la probabilidad de incumplimiento crediticio, Yield Management ( American Airlines, Lufthansa y SAS para estimar la demanda de pasajeros), etc.

En literatura

En la novela de Thomas Pynchon , El arco iris de gravedad , uno de los personajes, el estadístico Roger México, usa la ley de Poisson para mapear las áreas de impacto de los cohetes V2 alemanes en la ciudad de Londres durante la Segunda Guerra Mundial .

Notas y referencias

- Con las convenciones habituales 0! = 1 y 0 0 = 1 , la definición de la ley de Poisson se extiende a λ = 0 : entonces encontramos p (0) = 1 y, tan pronto como k > 0 , p ( k ) = 0 . Por lo tanto, es casi seguro que una variable aleatoria cero se puede considerar siguiendo la ley de Poisson del parámetro 0. Esta convención es consistente con las propiedades esenciales de la ley de Poisson del parámetro estrictamente positivo. Es conveniente, incluso esencial, por ejemplo, durante el estudio de los procesos puntuales de Poisson.

- Siméon-Denis Poisson, Investigación sobre la probabilidad de sentencias en materia penal y civil; precedido por las Reglas generales para el cálculo de probabilidades en Gallica , 1837, pasaje 81, p. 205.

- Véase, por ejemplo, Michel Henry, Alrededor del modelo de probabilidad , Presses Universitaires de Franche-Comté,2001( presentación en línea ) , pág. 229-231o estas notas del curso .

- (en) Eric W. Weisstein, " distribución de Poisson " en mathworld.wolfram.com

- (in) D Thomas Ahle, " Límites agudos y simples para los momentos crudos de las distribuciones Binomial y Poisson " , arXiv ,2021( arXiv 2103.17027 , leer en línea )

- (en) Norman L Johnson, Adrienne W Kemp y Samuel Kotz, univariante Discrete Distribuciones , Wiley,2005, 3 e ed. ( ISBN 978-0-471-27246-5 , leer en línea ) , pág. 162

- (en) Michael Mitzenmacher y Eli Upfal , Probabilidad y computación: algoritmos aleatorios y análisis probabilístico , Cambridge, Reino Unido, Cambridge University Press,2005( ISBN 978-0-521-83540-4 , leer en línea ) , pág. 97

- (en) " Una breve nota sobre los límites de la cola de Poisson "

- (in) Michael Short, " Desigualdades mejoradas para la distribución binomial y de Poisson y la cola superior de las funciones cuantiles " , Avisos de investigación académica internacional , vol. 2013,2013( DOI https://doi.org/10.1155/2013/412958 , leer en línea )

- (in) L. Le Cam , " Un teorema de aproximación para la distribución binomial de Poisson " , Pacific Journal of Mathematics , vol. 10, n o 4,1960, p. 1181-1197 ( leído en línea , consultado el 13 de mayo de 2009 ).

- (en) AD Barbour , L. Holst y S. Janson , aproximación de Poisson , Oxford, Clarendon Press, Oxford University Press,1992, 277 p. ( ISBN 0-19-852235-5 ).

- Ladislaus Bortkiewicz, Das Gesetz der kleinen Zahlen ,1898( leer en línea ), p. 23 .

![\ lambda \ in {}] 0, + \ infty [](https://wikimedia.org/api/rest_v1/media/math/render/svg/d64752215a3200cc640a035056f6d840f009fe0b)

![{\ Displaystyle \ lambda [1 \! - \! \ log (\ lambda)] \! + \! \ mathrm {e} ^ {- \ lambda} \ sum _ {k = 0} ^ {\ infty} {\ frac {\ lambda ^ {k} \ log (k!)} {k!}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/260583c8721f140a26b2fedd0ca7be11779647cd)

![{\ Displaystyle {\ begin {array} {lll} \ mathbb {E} [X] & = & \ lambda \\\ mathbb {E} [X ^ {2}] & = & \ lambda (1+ \ lambda) \\\ mathbb {E} [X ^ {3}] & = & \ lambda (1 + 3 \ lambda + \ lambda ^ {2}) \\\ mathbb {E} [X ^ {4}] & = & \ lambda (1 + 7 \ lambda +6 \ lambda ^ {2} + \ lambda ^ {3}) \ end {matriz}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4b5f229e400d5527be88286de93808928fee3fd0)

![{\ Displaystyle \ mathbb {E} [X ^ {n}] \ leq {\ frac {k ^ {k}} {\ ln \ left ({\ frac {k} {\ lambda}} + 1 \ right)} } \ leq \ lambda ^ {k} e ^ {\ frac {k} {2 \ lambda}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6f26f129702b3bd3e0c74db7007cd6598d8d8cf4)

![{\ Displaystyle \ mathbb {E} [X ^ {n}] = \ lambda \ mathbb {E} [X ^ {n-1}] + \ lambda {\ frac {\ partial \ mathbb {E} [X ^ { n-1}]} {\ parcial \ lambda}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ca9be13f332e8e03361fd2d757d4e7418692915d)

![{\ Displaystyle {\ begin {array} {lll} \ mathbb {E} [(X- \ lambda) ^ {2}] & = & \ lambda \\\ mathbb {E} [(X- \ lambda) ^ { 3}] & = & \ lambda \\\ mathbb {E} [(X- \ lambda) ^ {4}] & = & \ lambda (1 + 3 \ lambda) \\\ mathbb {E} [(X- \ lambda) ^ {5}] & = & \ lambda (1 + 10 \ lambda) \ end {matriz}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ca8e9b593d346b6915a7b04e1d6b473eea1b6c7b)

![{\ Displaystyle \ mathbb {E} [(X- \ lambda) ^ {n + 1}] = n \ lambda \ mathbb {E} [(X- \ lambda) ^ {n-1}] + \ lambda {\ frac {\ parcial \ mathbb {E} [(X- \ lambda) ^ {n}]} {\ parcial \ lambda}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/955a8a1c478f4348faa633d0b0bc3ce5781744c4)

![{\ Displaystyle {\ begin {alineado} V (X) & = \ mathbb {E} (X ^ {2}) - (\ mathbb {E} (X)) ^ {2} & \\ & = \ sum _ {k = 1} ^ {\ infty} k ^ {2} \, \ mathbb {P} (X = k) - \ lambda ^ {2} & \\ & = \ sum _ {k = 1} ^ {\ infty} k ^ {2} \, \ mathrm {e} ^ {- \ lambda} {\ frac {\ lambda ^ {k}} {k!}} - \ lambda ^ {2} & \\ & = \ lambda \, \ mathrm {e} ^ {- \ lambda} \ sum _ {k = 1} ^ {\ infty} \, {\ frac {k \ lambda ^ {k-1}} {(k-1)!} } - \ lambda ^ {2} & \\ & = \ lambda \, \ mathrm {e} ^ {- \ lambda} \ sum _ {k = 1} ^ {\ infty} \, {\ frac {d} { d \ lambda}} {\ frac {\ lambda ^ {k}} {(k-1)!}} - \ lambda ^ {2} & \ qquad ({\ text {toda la serie que tiene un radio de convergencia infinito,} } \\ & = \ lambda \, \ mathrm {e} ^ {- \ lambda} {\ frac {d} {d \ lambda}} \ sum _ {k = 1} ^ {\ infty} \, {\ frac {\ lambda ^ {k}} {(k-1)!}} - \ lambda ^ {2} & \ qquad {\ text {podemos invertir la suma y la derivación}}) \\ & = \ lambda \, \ mathrm {e} ^ {- \ lambda} {\ frac {d} {d \ lambda}} \ left [\ lambda \ sum _ {k = 1} ^ {\ infty} \, {\ frac {\ lambda ^ {k-1}} {(k-1)!}} \ right] - \ lambda ^ {2} & \ qquad ({\ text {reconocemos la expansión serial entera de}} \ mathrm {e} ^ {\ lambda}) \\ & = \ lambda \, \ mathrm {e} ^ {- \ lambda} {\ frac {d} {d \ lambda}} [\ lambda \, \ mathrm {e} ^ {\ lambda}] - \ lambda ^ {2} & \\ & = \ lambda \, \ mathrm {e} ^ {- \ lambda} (\ lambda +1) \, \ mathrm {e} ^ {\ lambda} - \ lambda ^ {2} & \\ & = \ lambda \, (\ lambda +1 ) - \ lambda ^ {2} & \\ & = \ lambda. & \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7b8c275017a53b44357fe83f517049c0073b4052)

![{\ Displaystyle \ mathbb {E} [S_ {n}]. \}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4169e81cf9921bebbec6592d094a01e875df7b5a)

![S_n = \ sum_ {k = 1} ^ {a_n} \, X_ {k, n} \ quad \ text {y} \ quad \ lambda_n \ = \ \ mathbb {E} [S_n] = \ sum_ {k = 1 } ^ {a_n} \, p_ {k, n}. \](https://wikimedia.org/api/rest_v1/media/math/render/svg/fa48961dc784a0fd1d047e71159fdd008492bea8)